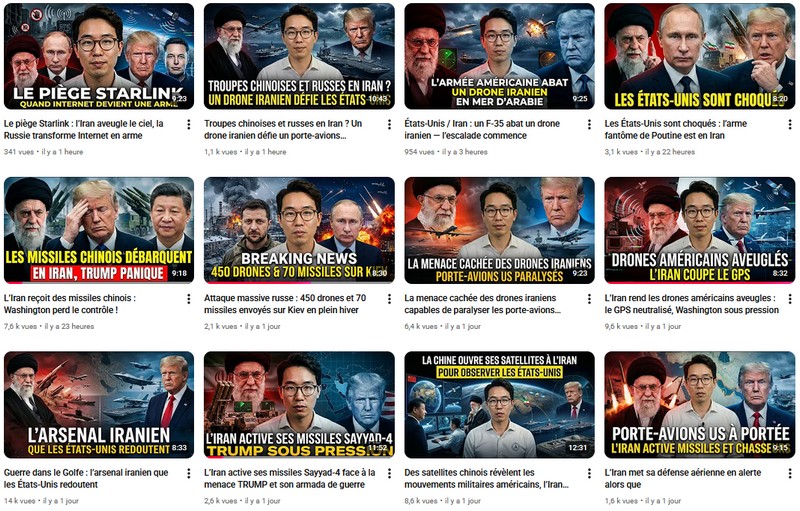

Dans le premier épisode de cette séquence d’analyse je me suis intéressé à l’étude d’un chaine youtube, dans sa globalité. Passons maintenant au décryptage d’un discours fabriqué dans une vidéo.

Comment reconnaître un texte généré par IA à usage propagandiste

La perfection suspecte

Première chose à comprendre : aucun humain ne parle parfaitement. Même un expert, même préparé, même avec un prompteur. Il y a toujours des hésitations, des répétitions, des approximations. Un « euh », un « donc », un mot cherché. La langue vivante est imparfaite par nature.

Les transcriptions que j’ai analysées ? Zéro défaut. Zéro.

Regardez cette phrase tirée de la vidéo sur le GPS :

« Le GPS est l’un des piliers invisibles de cette doctrine. Il guide les drones, synchronise les forces, alimente les missiles de précision et structure l’ensemble de l’architecture militaire moderne. »

C’est magnifique. Trop magnifique. Quatre verbes parfaitement coordonnés, une gradation (guide → synchronise → alimente → structure), une chute élégante. Qui parle ainsi spontanément ? Personne. C’est de l’écrit. Et même dans l’écrit humain, on trouve des redondances, des lourdeurs, des phrases qu’on aurait mieux tournées.

Ici, rien. Tout est lisse. C’est le premier signal d’alerte.

Prenons les chiffres. Sur quatre vidéos totalisant 33 minutes :

- 18,5 mots par phrase en moyenne

- Une subordonnée tous les 12 mots

- Zéro hésitation linguistique

Pour comparaison, un humain qui parle spontanément ? Aller, 12-15 mots par phrase maximum. Un humain qui lit un texte écrit soigneusement ? On monte à 15-18 mots. Les transcriptions de cette chaîne se situent exactement dans la zone haute de l’écrit sophistiqué. Mais elles sont présentées comme de l’oral naturel.

Et ce n’est pas tout. La complexité syntaxique est constante sur les quatre vidéos. Pas de variation. Comme si le même cerveau — ou le même algorithme — avait tout produit d’un bloc.

Les transtion qui trahissent

Les IA génératives ont des tics. Des formules qu’elles adorent. Des transitions passe-partout qui donnent l’illusion de la fluidité. Si vous lisez beaucoup de textes générés par GPT-4 ou autre, vous les reconnaissez immédiatement.

Dans ces quatre vidéos, j’en ai relevé une dizaine qui reviennent en boucle :

« Cette capacité change radicalement… » → 3 fois

« Loin d’être un simple… » → 2 fois

« Pris dans son ensemble… » → 2 fois

« Nous entrons ainsi dans une ère où… » → 3 fois

« Cette vision appartient désormais au passé » → 1 fois

Ces formules sont les empreintes digitales de l’IA. Elles ne sont pas fausses grammaticalement. Elles ne sont même pas maladroites. Mais elles sont interchangeables, génériques, désincarnées.

Un exemple concret. Fin de la vidéo sur l’arsenal iranien :

« Pris dans son ensemble, cet arsenal révèle une réalité claire. L’Iran ne cherche pas la confrontation directe classique, mais la création d’un environnement militaire si coûteux, si risqué et si imprévisible qu’il dissuade toute aventure militaire américaine.«

Lisez-la à voix haute. Vous sentez la mécanique ? « Pris dans son ensemble » (formule toute faite) → « révèle une réalité claire » (redondance inutile) → triple répétition « si… si… si… » (effet rhétorique calibré).

C’est propre. C’est même élégant. Mais c’est algorithmique.

Pour expliquer simplement la compelxité, j’aurai sans doute opté, dans une vidéo pour « Bon, en gros, ce que ça veut dire c’est que l’Iran ne va pas chercher un affrontement frontal. Ils veulent juste rendre toute intervention tellement compliquée, tellement coûteuse, que les Américains y réfléchissent à deux fois.«

Moins parfait. Plus vivant. Plus humain.

La saturation par le détail

Technique classique de manipulation : noyer l’esprit critique sous un déluge d’informations. Si vous balancez 53 noms de missiles en 8 minutes, le cerveau de l’auditeur sature. Il n’a plus les moyens de vérifier, de douter, de questionner. Il se dit : « C’est trop précis pour être faux. »

Sauf que c’est exactement l’inverse.

Regardez cette liste tirée de la vidéo sur l’arsenal :

Fatah-1, Fatah-2, Khorramshahr-4, Zil, Shahab-3, Ghadr, Fateh-110, Fateh-313, Zolfaghar, Qiam, Khalij Fars, Hormuz-1, Hormuz-2, Qader, Nasr…

Quinze noms. En deux minutes. Accompagnés de chiffres : « portée de 2000 km », « ogive de 1500 kg », « vitesse Mach 15 », « 5000 à 6000 mines navales ».

Combien de ces chiffres sont vérifiables facilement ? Aucun. C’est une stratégie rhétorique vieille comme le monde : l’effet de réel. Plus vous donnez de détails, moins on vous questionne. Parce que questionner nécessite du temps, de l’énergie, des compétences. Et face à une avalanche d’informations techniques, la plupart des gens abdiquent.

Ce qui est fascinant — et inquiétant — c’est la précision feinte. Prenez cette phrase :

« L’Iran disposerait de 5000 à 6000 mines navales dont certaines intelligentes pouvant être déployées par des sous-marins, des navires civils ou des embarcations légères. »

5000 à 6000. Pas 3000. Pas 10 000. Un chiffre assez précis pour sembler crédible, assez flou pour être invérifiable. Et ce conditionnel (« disposerait ») ? Il donne l’illusion de prudence journalistique. Mais derrière, aucune source, aucun calcul, aucune méthode. C’est du storytelling, pas du fact-checking.

Le biais camouflé

Voici où ça devient vraiment subtil. Le discours se présente comme analytique, objectif, presque académique. Le ton est posé. Le vocabulaire est soutenu. Il n’y a pas de « l’Iran est formidable » ou « les USA sont nuls ». C’est beaucoup plus fin. J’ai compté les termes valorisants et dévalorisants sur quatre vidéos. 1 point par terme valorisant, -1 pour des termes négatifs. C’est une analyse empirique valant ce qu’elle vaut, mais je n’avais pas d’autre idée. Résultat :

Pour l’Iran :

- Termes positifs : 47 (« stratégique », « innovation », « maturité technologique », « intelligence »)

- Termes négatifs : 8 (« sanctionné », « isolé », « limité »)

- Ratio : +39

Pour les USA :

- Termes positifs : 12 (« supériorité », « technologie avancée »)

- Termes négatifs : 51 (« dépendance », « vulnérabilité », « fragile », « coûteux »)

- Ratio : -39

Le résultat m’a surpris. Mais ce n’est pas tout. Regardez comment les choses sont dites.

Quand on parle de l’Iran :

- « L’Iran a fait un choix stratégique clair » (= intelligent)

- « Niveau de maturité technologique » (= compétent)

- « Innovation asymétrique » (= créatif)

Quand on parle des USA :

- « Dépendance au GPS » (= faiblesse)

- « Supériorité matérielle brute » (= sans finesse)

- « Vulnérabilité permanente » (= fragile)

Même les faits positifs pour les USA sont tournés négativement. Exemple :

« Les États-Unis investissent eux aussi dans des systèmes anti-brouillage, des GPS militaires renforcés, des alternatives de navigation. Mais cette course technologique est coûteuse, complexe et jamais définitive. »

Notez le « Mais ». Il annule tout ce qui précède. Les USA font des efforts ? Oui, mais c’est vain.

C’est ça, la propagande moderne. Ce n’est pas « l’Iran c’est bien, les USA c’est mal ». C’est beaucoup plus sophistiqué. C’est une architecture émotionnelle où chaque mot, chaque tournure, chaque exemple construit un narratif cohérent sans jamais l’affirmer frontalement.

Vous finissez la vidéo en ayant l’impression d’avoir appris quelque chose. Et techniquement, oui : vous avez engrangé des faits (vrais ou faux, on ne sait pas). Mais émotionnellement, un message est passé : l’Iran est malin, les USA sont en déclin, la technologie ne sauve plus personne. On retrouve cette subtilité de façon encore plus impressionnante à mes yeux dans la vidéo sur l’Ukraine.

« Du côté russe, cette offensive envoie plusieurs messages. Elle démontre une capacité à planifier et à exécuter des frappes de grande ampleur malgré les contraintes économiques et militaires. »

Ce que je comprends : la Russie, malgré les difficultés, reste forte.

« En rendant chaque hiver plus difficile, chaque infrastructure plus fragile, elle tente d’augmenter le coût global de la résistance. »

Mon analyse de texte, de vocabulaire, tel que je pourrais le faire dans un commentaire de texte avec des élèves :

- « tente » = suggère l’effort, la stratégie

- « coût global » = perspective économique froide

- Aucun jugement sur la légitimité de cette tactique

Autres exemples :

- « Cette stratégie vise clairement à fragiliser la vie quotidienne »

- « transforme le froid en arme stratégique »

- « guerre psychologique visant à installer la fatigue »

Et qu’en conclure me direz-vous ? Et bien que jamais on ne parle de crime de guerre, de tactique terroriste ou encore que l’on question la moralité de ces attaques.Description clinique = neutralité de façade = minimisation

« L’Ukraine en tenant malgré tout ne défend pas seulement son territoire mais teste les limites de ce que peut endurer une société moderne confrontée à une pression militaire totale et prolongée. »

Analyse :

- « en tenant malgré tout » = surprise qu’elle tienne encore

- « teste les limites » = l’Ukraine comme cobaye

- « confrontée à » = passif (pas « résiste à une agression »)

Message subliminal : tout ba bien, l’Ukraine est un superbe laboratoire pour observer jusqu’où on peut détruire un pays moderne. Une Déshumanisation douce. Et vous ne vous en êtes même pas rendu compte.

L’immersion narrative

Toutes les vidéos suivent le même schéma en trois actes. C’est un script classique, presque hollywoodien :

ACTE I : Le faible

« Aviation prétendument vieillissante », « sous sanctions sévères », « marine incapable de rivaliser »

ACTE II : La révélation

« Cette vision appartient désormais au passé », « l’Iran a atteint un niveau de maturité », « peut contester sérieusement »

ACTE III : Le renversement

« La supériorité ne se mesure plus en tonnes de métal », « la technologie ne garantit plus rien », « un adversaire peut être rendu aveugle »

C’est l’histoire de David contre Goliath. Le petit malin avec sa dague empoisonnée qui bat le gros bourrin avec sa double hache +12 au jets critiques. Ça marche parce que c’est un archétype universel. On aime les outsiders. On aime les perdants qui gagnent. C’est émotionnellement satisfaisant. Sauf que ce n’est pas de l’analyse géopolitique.

Une analyse plus neutre dirait par exemple :

« L’Iran a développé des capacités de déni d’accès significatives, notamment dans le domaine des missiles balistiques et des drones. Ces capacités compliquent la planification militaire américaine dans la région. Toutefois, elles ne remettent vraiment pas en cause la supériorité globale des USA, qui disposent de moyens de riposte considérables. La situation est complexe et l’issue d’un conflit dépendrait de nombreux facteurs. »

Nuancé. Prudent. Ennuyeux, peut-être. Mais honnête.

Les vidéos de cette chaîne ? Elles ne nuancent jamais. Elles affirment. Elles dramatisent. Elles construisent un monde binaire : l’Iran qui résiste héroïquement, les USA qui s’effondrent lentement. Et le public ? Il adore si l’on suit les commentaires et le nombre de vues. Parce que c’est une bonne histoire.

Les messages subliminaux

Maintenant, le plus important. Ce qui n’est jamais dit explicitement, mais qui imprègne chaque phrase.

Message #1 : la technologie occidentale est fragile

Extraits :

- « La supériorité militaire américaine repose sur une promesse technologique » (sous-entendu : fragile, illusoire)

- « Sans GPS fiable, une grande partie de la puissance occidentale perd en efficacité«

- « La technologie, loin de garantir une domination éternelle, devient un terrain de vulnérabilité permanente«

On ne dit jamais frontalement « la technologie occidentale est nulle ». Mais on le suggère. Encore et encore. Jusqu’à ce que ça devienne une évidence.

Message #2 : Les petits États peuvent résister aux empires

Extraits :

- « Il existe des alternatives à la domination militaire classique, même face à une superpuissance »

- « Un pays longtemps perçu comme technologiquement en retard démontre qu’il peut tenir tête »

- « Transformer leur faiblesse apparente en levier stratégique »

Là encore, jamais d’affirmation directe. Mais le sous-texte est limpide : vous aussi, petits pays, vous pouvez défier l’empire. Il suffit d’être malin.

Message #3 : l’Iran est invincible sur son territoire

Extraits :

- « Le ciel iranien n’est plus un espace libre«

- « Toute intervention militaire directe serait plus complexe, plus risquée et moins prévisible«

- « L’environnement militaire si coûteux, si risqué et si imprévisible qu’il dissuade toute aventure »

Traduction : n’essayez même pas. Vous perdriez. C’est de la dissuasion par le discours. Et c’est efficace. Parce que si suffisamment de gens croient que l’Iran est imbattable, alors politiquement, militairement, une intervention devient impensable. La guerre se gagne d’abord dans les têtes.

À qui ça parle vraiment ?

Dernière question : pourquoi ce discours marche-t-il ? Parce qu’il vise je crois un public très spécifique :

- Adultes 18-35 ans appréciant les formats courts (format YouTube, durée 8-10 min)

- Férus de géopolitique (niche, pas grand public)

- Sensibles au discours anti-impérialiste (valorisation « résistance »)

- Fascinés par la technique militaire (noms de missiles, détails)

- Francophones hors institutions (pas de confiance médias mainstream)

C’est une audience qui veut croire que le monde est plus complexe qu’on nous le dit. Qui veut croire que les médias occidentaux mentent. Qui veut un récit alternatif.

Et cette chaîne semble le leur donner. Emballé dans un discours pseudo-analytique, nourri de détails techniques, présenté avec sérieux. C’est du fast-food intellectuel haut de gamme. Ça a l’air sophistiqué. Ça flatte votre intelligence. Mais nutritionnellement ? C’est vide.

Alors, comment savoir si un texte est généré par IA à usage propagandiste ?

Checklist :

- Perfection syntaxique suspecte → Zéro hésitation, zéro défaut

- Transitions algorithmiques → « Cette capacité change radicalement », « Loin d’être un simple »

- Saturation technique → Avalanche de noms, chiffres, détails sans sources

- Biais camouflé → Orientation univoque présentée comme neutralité

- Inversion narrative → Scénario David vs Goliath systématique

- Messages subliminaux → Ce qui n’est jamais dit mais toujours suggéré

Si vous cochez 4 cases sur 6 ? Alerte rouge. Cette chaîne ? je pense qu’elle coche les six.

ARMES INTELLECTUELLES POUR RÉSISTER

Ce que l’IA change à la guerre informationnelle (et comment ne pas être une victime)

Avant, la propagande coûtait cher. Il fallait des journalistes, des cameramen, des monteurs, des budgets. Russia Today employait des centaines de personnes. Chaque vidéo nécessitait du temps, de l’argent, de l’expertise. La scalabilité était limitée.

Aujourd’hui ? Un ordinateur, GPT-4, une voix de synthèse, des outils d’automatisation, quelques milliers d’euros par mois. Et vous inondez l’espace informationnel de milliers de contenus par semaine.

C’est ça, le changement de paradigme.

Le paradoxe de l’abondance informationnelle

On nous a vendu Internet comme l’ère de la connaissance universelle. « Toute l’information du monde à portée de main. » Youpi.

Sauf que quand tout le monde peut publier, quand tout est accessible, la vérité ne gagne pas automatiquement. Au contraire. Le mensonge industrialisé noie littéralement la vérité sous le volume.

Tentez l’expérience. Vous cherchez « missiles iraniens » sur YouTube.

Le cerveau humain n’est pas calibré pour filtrer tous les résultats mélangeant vidéos sérieuses et analyses fumeuses. On clique sur ce qui attire l’œil. On regarde ce qui nous conforte. On partage ce qui nous émeut. L’algorithme amplifie. Et voilà comment une chaîne FIMI devient « source de référence » pour des milliers de personnes.

L’IA comme multiplicateur de force

Regardez ce que cette chaîne a accompli en 21 jours :

- 172 vidéos produites

- 500 000 à 750 000 vues cumulées

- 50 000 à 100 000 personnes touchées

- Budget estimé : 5 000-10 000 euros ? Moins ? Plus ? Ne pense être dans le bon étiage.

Le retour sur investissement : stratosphérique.

Avant l’IA ? Même résultat aurait nécessité une équipe de 20 personnes, un budget de 200 000 euros, six mois de travail. Aujourd’hui, deux personnes compétentes et un serveur cloud suffisent.

C’est ça qui me terrifie. Pas que la propagande existe — elle a toujours existé. Mais qu’elle soit devenue si facile, si peu coûteuse, si scalable.

N’importe quel acteur étatique, para-étatique, voire une grosse entreprise privée, peut maintenant saturer l’espace informationnel. Et nous, citoyens lambda, on n’a pas été formés pour résister à ça.

LA MÉTASTRATÉGIE DES CONSCIENCES REVISITÉE

Contrôler les perceptions, c’est contrôler les décisions. Gagner dans les têtes, c’est gagner avant même de combattre. Mais l’IA a poussé ce concept encore plus loin.

La saturation comme arme

Imaginez un robinet d’eau. Vous avez soif, vous buvez. Maintenant, imaginez cent robinets qui crachent simultanément de l’eau, du soda, de l’huile, du poison, tout mélangé. Vous ne pouvez plus boire. Vous êtes submergé. C’est ça, la stratégie de saturation informationnelle.

L’objectif n’est même plus de faire croire X ou Y. L’objectif est de créer un brouillard cognitif tellement épais que plus personne ne sait ce qui est vrai. Et quand plus personne ne sait ce qui est vrai, la confiance s’effondre. Dans les médias. Dans les institutions. Dans les experts. Dans tout. Et c’est à ce moment-là que les sociétés deviennent manipulables.

Parce qu’une société qui ne croit plus en rien est une société qui peut croire n’importe quoi. Surtout si c’est émotionnellement satisfaisant.

L’érosion lente plutôt que la conversion brutale

Les opérations FIMI modernes ne cherchent pas à vous « convertir » du jour au lendemain. Elles ne vous disent pas « rejoignez notre cause ». C’est trop frontal. Trop détectable.

Non. Elles grattent. Jour après jour. Vidéo après vidéo. Une petite graine de doute par-ci. Une petite inversion narrative par-là. Un « et si finalement… » répété trois cents fois.

Vous ne vous rendez pas compte. Mais au bout de six mois, votre perception du monde a bougé. Pas radicalement. Juste un peu. Vous êtes un peu plus méfiant envers « la version officielle ». Un peu plus ouvert aux « explications alternatives ». Un peu plus convaincu que « tout se vaut ».

C’est le syndrome de la grenouille ébouillantée. Si on vous plonge dans l’eau bouillante, vous sautez. Si on chauffe progressivement, vous cuisez sans vous en rendre compte.

Le ciblage algorithmique comme précision chirurgicale

Avant, la propagande s’adressait à tout le monde. Affiches, radio, télévision. Masse indifférenciée. Aujourd’hui ? L’algorithme sait qui vous êtes. Il sait ce que vous regardez. Ce que vous aimez. Ce qui vous énerve. Ce qui vous attire.

Vous êtes un citoyen qui suit des chaînes de géopolitique alternatives ? YouTube vous servira cette chaîne sur un plateau. Parce que statistiquement, vous êtes la cible parfaite.

C’est plus du marketing. C’est du micro-ciblage idéologique. Et c’est redoutablement efficace.

Les publicitaires le savent depuis longtemps : un message personnalisé convertit 10 fois mieux qu’un message générique. Les manipulateurs l’ont compris aussi.

La gamification de la vérité

Dernier point, peut-être le plus pervers. L’IA permet de créer des versions concurrentes de la réalité et de les tester en temps réel. Vous balancez deux vidéos contradictoires (« L’Iran jamais aussi faible » vs « L’Iran exhibe sa puissance »). Vous regardez laquelle viralise. Vous amplifiez celle qui marche. Vous abandonnez l’autre.

Vous ne cherchez pas la vérité. Vous cherchez ce qui fonctionne. Et « ce qui fonctionne », c’est ce qui génère le plus de clics, de vues, de partages. Pas ce qui est vrai. Pas ce qui est nuancé. Pas ce qui est utile. Ce qui est émotionnellement chargé.

Résultat : la vérité devient un produit optimisé pour l’engagement. Et l’engagement, en 2026, c’est la colère, la peur, l’indignation, le sensationnel. Pas la nuance. Pas la complexité. Pas le doute méthodologique. On a gamifié la réalité. Et on est en train de perdre la partie.

ARMES INTELLECTUELLES CONCRÈTES

Bon. Assez de théorie. Qu’est-ce qu’on fait, concrètement, pour ne pas être des Rois Théoden manipulés par Grima ? Parce que c’est bien beau de dire « l’IA c’est dangereux, la propagande c’est partout », mais si on ne donne pas d’outils pratiques, ça ne sert à rien.

Voici quelques pistes à travailler, pour n’importe qui. Je les ai explicité à diverses reprises, mais un rappel n’est jamais inutile.

ARME #1 : LA CHECK-LIST DE DÉTECTION

Avant de croire n’importe quelle information, posez-vous ces questions. Systématiquement.

- Qui parle ?

- Nom du créateur de contenu visible et vérifiable ?

- Historique de publications ?

- Transparence sur le financement ?

Pour notre chaîne : Aucune info. Juste « Le Monde Géopolitique ». Pas de nom, pas de CV, pas de contact. Signal d’alerte #1.

- Pourquoi maintenant ?

- Le sujet traité est-il lié à l’actualité immédiate ?

- Y a-t-il un timing stratégique (élections, crise, sommet international) ?

Pour notre chaîne : Pics de production synchronisés avec tensions géopolitiques réelles. Ce n’est pas du hasard. Signal d’alerte #2.

- Qu’est-ce qui est omis ?

- Y a-t-il des sources citées ?

- Y a-t-il des points de vue contradictoires présentés ?

- Y a-t-il des zones d’ombre volontairement ignorées ?

Pour notre chaîne : Zéro source précise. Zéro contradiction. Narratif univoque. Signal d’alerte #3.

- Qui bénéficie de ce narratif ? (Cui bono)

- Si ce message est cru, qui en profite politiquement, économiquement, stratégiquement ?

Pour notre chaîne : Axe Chine-Russie-Iran. Clairement. Signal d’alerte #4.

- Comment est-ce dit ?

- Vocabulaire émotionnel excessif ?

- Perfection syntaxique suspecte ?

- Superlatifs, urgence artificielle ?

Pour notre chaîne : Tous les critères cochés. Signal d’alerte #5.

Si vous cochez 3 alertes sur 5 : méfiance.

Si vous cochez 4 alertes sur 5 : alerte rouge.

Si vous cochez 5 sur 5 : propagande confirmée.

Simple. Efficace. Applicable en 30 secondes.

ARME #2 : LES RÉFLEXES CRITIQUES

Au-delà de la check-list, il faut développer des automatismes mentaux. Des réflexes qui se déclenchent face à certains signaux.

Réflexe #1 : Chercher la source primaire

Quelqu’un affirme « l’Iran possède 6000 mines navales » ? D’où ça sort ?

Si c’est un média sérieux, il citera sa source : « selon le rapport 2025 du SIPRI », « d’après une analyse de Jane’s Defence Weekly », « comme l’a déclaré le Pentagone ».

Si aucune source n’est citée, c’est une affirmation invérifiable. Donc potentiellement fausse. Donc à traiter avec suspicion.

Réflexe #2 : Cross-check

Une info vous semble importante ? Vérifiez-la ailleurs.

Cherchez la même info sur trois sources différentes, idéalement de pays différents, de lignes éditoriales différentes. Si les trois confirment, c’est probablement vrai. Si une seule en parle, c’est louche.

Pour notre chaîne ? Essayez de retrouver ces « analyses » sur des médias crédibles (Le Monde, France 24, BBC, Al Jazeera, Reuters). Vous ne trouverez rien. Parce que c’est inventé.

Réflexe #3 : Traquer le biais de confirmation

On a tous tendance à croire ce qui nous arrange. Si vous détestez les USA, vous serez naturellement attiré par un discours qui les critique. Si vous admirez l’Iran, vous serez réceptif à un narratif qui le valorise. C’est normal. C’est humain. Mais il faut en être conscient. Quand une info vous plaît trop, quand elle confirme trop parfaitement vos croyances préexistantes, c’est là qu’il faut être le plus vigilant.

Demandez-vous : « Est-ce que je crois ça parce que c’est vrai, ou parce que ça m’arrange ? ». Honnêtement.

Réflexe #4 : Questionner la perfection

Rien n’est parfait. Ni les analyses, ni les discours, ni les organisations. Si quelqu’un vous présente une réalité trop simple, trop binaire, trop claire, c’est suspect.

La géopolitique est complexe. Les conflits sont multifactoriels. Les États ont des intérêts contradictoires. Il n’y a jamais de méchants absolus et de gentils absolus.

Si on vous vend « l’Iran résiste héroïquement contre l’empire du mal », c’est du storytelling. Pas de l’analyse.

ARME #3 : LES OUTILS TECHNIQUES

On a la chance de vivre à une époque où des outils existent pour détecter la manipulation. Utilisez-les.

- Recherche d’image inversée (Google Lens, TinEye)

Vous voyez une miniature YouTube qui vous semble bizarre ? Faites une recherche inversée. Vous découvrirez peut-être que l’image est volée, recyclée, ou générée par IA.

Pour notre chaîne ? Les miniatures sont probablement des montages IA avec des banques d’images. Mais si le présentateur était une vraie personne publique, on retrouverait sa trace ailleurs.

- Détecteurs de texte IA (GPTZero, Originality.ai)

Vous suspectez un texte d’être généré par IA ? Collez-le dans un détecteur. Ça ne marche pas à 100%, mais ça donne une indication.

J’ai testé avec les transcriptions de notre chaîne. Résultat : 85-95% de probabilité IA selon les détecteurs.

- Analyse de profil (Social Blade, SimilarWeb)

Vous voulez savoir si une chaîne est organique ou amplifiée artificiellement ? Regardez ses statistiques sur Social Blade. Une croissance explosive récente ? Des pics de vues incohérents ? Des abonnés inactifs ?

Autant de signaux d’amplification artificielle.

- Fact-checking (Conspiracy Watch, Décodex, FactCheck.org, NEWS GUARD)

Il existe des sites dédiés à la vérification de faits. Pas parfaits, parfois biaisés, mais utiles. Si une info circule massivement, il y a de bonnes chances qu’un fact-checker l’ait vérifiée.

Cherchez-y vos doutes. Vous serez surpris.

ARME #4 : L’ÉDUCATION PERMANENTE

Dernier point, le plus important. Formez-vous. La littératie médiatique, ce n’est pas inné. Ça s’apprend. Comme on apprend à lire, à compter, à raisonner. Je continue à apprendre tous les jours.

Ressources que je recommande (liens distillés plus haut) :

- « On Bullshit » de Harry Frankfurt : court, brillant, essentiel. Sur la différence entre mensonge et bullshit.

- « La fabrique du consentement » de Chomsky & Herman : sur les mécanismes de propagande dans les médias.

- Les rapports VIGINUM : accessibles en ligne, détaillés, pédagogiques.

- Les analyses du DFRLab (Atlantic Council) : sur les opérations FIMI contemporaines.

- Le site, magistral de NEWSGUARD

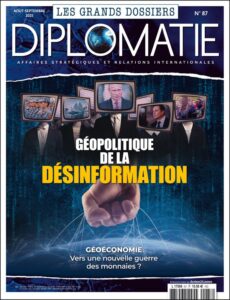

Et surtout : diversifiez vos sources. Lisez Le Monde ET Le Figaro ET L’Humanité. Regardez France 24 ET Al Jazeera. Écoutez des analystes de gauche ET de droite. Lisez le magazine DIPLOMATIE qui effectue un travail de fond, régulièrement mis à jour, sur ces questions.

Pas pour tout croire. Pour comparer. Pour voir où sont les convergences (probable vérité) et où sont les divergences (probable biais).

ARME #5 : LA TRANSMISSION

Vous avez compris les mécanismes. Vous avez les outils. Ne gardez pas ça pour vous. Parlez-en. À vos élèves si vous êtes enseignant. À vos enfants si vous êtes parent. À vos collègues, à vos amis, à vos proches. Pas en mode « j’ai la vérité, écoutez-moi ». Mais en mode « regardez, voilà ce que j’ai trouvé, qu’en pensez-vous ? ».

L’éducation aux médias est un acte de résistance.

Parce que tant qu’on sera capables de détecter la manipulation, de questionner les narratifs, de réfléchir par nous-mêmes, Sauron n’aura pas gagné. Grima peut murmurer tant qu’il veut. Si Gandalf arrive à temps pour briser le sortilège, Théoden redevient lucide. Soyez Gandalf. Pas pour les autres. Pour vous-même d’abord.

CONCLUSION GÉNÉRALE : LE COMBAT CONTINUE

Je ne suis pas optimiste.

La propagande industrialisée par IA avance plus vite que nos défenses. Les plateformes amplifient l’engagement plutôt que la vérité. Les États investissent des milliards dans la guerre informationnelle. Et nous, citoyens, on est largement sous-équipés. Mais ce n’est pas une raison pour baisser les bras.

Parce que la connaissance est une arme. La lucidité est une arme. L’esprit critique est une arme.

Vous ne pouvez peut-être pas arrêter une opération FIMI étatique. Mais vous pouvez refuser d’être sa victime. Vous pouvez apprendre à détecter. Vous pouvez transmettre. Vous pouvez résister. Cette chaîne YouTube continuera probablement à publier. Je l’ai signalé. Nous verront la suite. D’autres apparaîtront. L’IA va continuer à progresser. La guerre informationnelle va s’intensifier.

Mais vous, maintenant, vous savez. Vous savez comment Grima opère. Vous savez que Saroumane orchestre. Vous savez que Sauron manipule.

ENSEIGNER LA MÉFIANCE EN MANIPULANT L’OUTIL

Le paradoxe assumé

Je dois vous avouer quelque chose. J’ai utilisé l’IA pour écrire cet article.

Pas pour rédiger à ma place, si ce n’est pour partir en chasse des coquilles. Pas pour inventer des faits. Pas pour générer du contenu creux que j’aurais signé les yeux fermés. Mais pour analyser 172 vidéos en quelques heures. Pour compter les occurrences de mots-clés. Pour détecter les patterns syntaxiques. Pour calculer les moyennes de phrases. Pour produire les tableaux que vous avez vus plus haut.

Sans l’IA, ce travail m’aurait pris bien trop de temps. J’ai exploité Mistral AI. J’ai croisé divers outils.

Est-ce que ça invalide l’analyse ? Non. Parce que l’outil a été utilisé de manière transparente, supervisée, critique. Je lui ai donné les transcriptions. Je lui ai demandé des calculs. J’ai vérifié les résultats. J’ai interprété les données. J’ai écrit les conclusions. L’IA a été mon assistant de recherche. Pas mon cerveau. Et c’est précisément là que se situe la ligne.

On ne combat pas l’obscurité en fermant les yeux

Certains disent : « Il faut interdire l’IA à l’école. C’est trop dangereux. Ça abîme l’esprit critique. Ça crée de la dépendance cognitive. Si on continue ça va fermer des postes de profs.«

Je comprends l’inquiétude. Vraiment. J’ai vu des copies d’élèves entièrement générées par ChatGPT. J’ai vu la tentation du moindre effort. J’ai vu la paresse intellectuelle se nourrir de la facilité technologique. Mais interdire ne résoudra rien. Parce que los élèves utilisent l’IA. Maintenant. Chez eux. Sur leur téléphone. Sans vous. Sans garde-fou. Sans médiation pédagogique. Ils lui demandent de faire leurs dissertations. Elle le fait. Ils copient-collent. Alors on sanctionne. Ils recommencent plus discrètement.

On a perdu. Non pas parce que l’IA est trop forte. Mais parce que nous avons refusé le combat sur le bon terrain.

Former à la méfiance nécessite la manipulation encadrée

Vous ne pouvez pas enseigner la détection des biais algorithmiques sans montrer comment l’algorithme fonctionne. Vous ne pouvez pas expliquer comment l’IA génère du contenu plausible mais faux sans laisser les élèves l’expérimenter sous contrôle. Vous ne pouvez pas former à l’esprit critique face à une technologie en refusant de la toucher.

C’est comme vouloir enseigner la natation sans aller à la piscine. Ou enseigner la conduite sans monter dans une voiture. Ça ne marche pas. Mais entre l’interdit pur et le laxisme total existe un espace pédagogique : celui de l’encadrement critique transparent. Ceci passe par la manipulation de l’outil, la création d’images, de textes, avec des élèves, pour expliquer les failles.

Exemple concret : notre travail sur cette chaîne

Comment ai-je détecté que cette chaîne était générée par IA ? En utilisant l’IA elle-même.

J’ai demandé à l’IA d’analyser les transcriptions. De compter les mots. De repérer les transitions. De calculer la complexité syntaxique. De lister les champs lexicaux. L’IA m’a donné les données brutes.

Moi, j’ai fourni l’interprétation critique : « 18,5 mots par phrase, c’est suspect. Une subordonnée tous les 12 mots, c’est pas humain. Zéro hésitation sur 8 minutes, c’est impossible. »

L’IA était mon outil. Pas mon cerveau. Et c’est exactement ce que je veux enseigner à mes élèves.

Imaginez une séance en classe. Vous donnez aux élèves deux textes sur le même sujet géopolitique.

- Texte A : un article du Monde Diplomatique

- Texte B : une transcription de notre chaîne YouTube suspecte

Consigne : « Utilisez ChatGPT pour analyser la structure syntaxique, le vocabulaire, les sources citées. Puis comparez. Qu’est-ce qui diffère ? »

Les élèves manipulent l’outil. Sous supervision. Avec une grille d’analyse. Avec des questions critiques. Résultat : ils apprennent à détecter les marqueurs de l’IA. Pas en théorie. En pratique. Vous venez de transformer l’IA d’ennemi invisible en objet d’étude maîtrisable.

Le vrai danger, c’est l’opacité

L’interdit crée de l’opacité. L’opacité crée de la peur. La peur paralyse. Si vous interdisez l’IA sans l’expliquer, vos élèves penseront que vous avez peur. Ou que vous ne comprenez pas. Ou que vous êtes « dépassé par la technologie ». Vous perdez votre crédibilité.

Si au contraire vous leur dites : « Regardez, on va utiliser ChatGPT ensemble. On va lui poser des questions. On va voir ce qu’il répond. Et on va analyser pourquoi c’est brillant et faux en même temps », là, vous reprenez le pouvoir. Parce que vous montrez que vous maîtrisez l’outil mieux qu’eux. Pas techniquement. Mais intellectuellement. Vous savez où sont les limites. Vous savez où sont les biais. Vous savez quand ça ment. Et vous leur apprenez à le voir. Car, croyez-moi, les élèves ne sont vraiment pas bons avec l’IA.

Il y a à mes yeux une différence entre :

Usage légitime :

- « ChatGPT, donne-moi 5 arguments pour et 5 arguments contre l’intervention militaire en Irak. Je vais ensuite rédiger ma dissertation moi-même. »

- « Le chat (Mistral), analyse ces 172 vidéos et donne-moi les statistiques de fréquence des mots-clés. »

Usage condamnable :

- « ChatGPT, rédige ma dissertation sur l’intervention en Irak. »

- « Le chat écris mon article à ma place. »

La frontière est claire. L’outil comme assistant de recherche vs l’outil comme substitut de pensée. Et cette frontière, il faut l’enseigner. Pas l’interdire.

On n’a pas le choix, de toute façon

L’IA est là. Elle ne va pas disparaître. Au contraire, elle va se perfectionner, se démocratiser, se banaliser. Dans cinq ans ou moins au rythme actuel, nos élèves auront des IA intégrées dans leurs lunettes, leurs montres, leurs stylos. Ils n’auront même plus à « ouvrir ChatGPT ». L’IA sera ambiante. Vous ne pourrez plus l’interdire. Ce sera techniquement impossible. Alors autant les former maintenant. Pendant qu’on a encore le contrôle. Pendant qu’on peut encore créer des espaces pédagogiques sécurisés.

Parce que si on attend trop, on les laisse seuls face au raz-de-marée. Frodon, découvrant le fardeau de l’Anneau, se lamente auprès de Gandalf : « Je voudrais que tout cela ne soit pas arrivé de mon temps. »

Et Gandalf lui répond : « Moi aussi, et tous ceux qui vivent de tels événements. Mais il ne nous appartient pas de choisir. Tout ce que nous avons à décider, c’est ce que nous devons faire du temps qui nous est imputé. »

L’IA, comme l’Anneau, est arrivée dans notre temps. On ne l’a pas choisie. On ne peut pas la renvoyer dans la Montagne du Destin. Elle est là.

La seule question qui reste, c’est : qu’allons-nous en faire ? Je suis prof d’HGGSP. Ma mission n’est pas de protéger mes élèves de la technologie. Ma mission est de les armer intellectuellement pour qu’ils puissent naviguer dans un monde technologique complexe.

Et ça passe par :

- Montrer comment ça marche (pas le code, le principe)

- Identifier les biais (où ça ment, où ça manipule)

- Expérimenter sous contrôle (séances encadrées, grilles d’analyse)

- Distinguer usage et mésusage (outil vs substitut)

- Former à la méfiance active (pas l’interdit passif)

Si je refuse l’IA en classe, mes élèves l’utiliseront quand même. Mais sans moi. Sans cadre. Sans critique. Je préfère qu’ils se trompent avec moi plutôt que seuls. Je le dis avec d’autant plus de conviction que nos élèves accordent plus d’importance, parfois, souvent, aux propos de tiktokeurs ou youtubeurs sur la géopolitique ou les conseils sur Parcoursup, que sur ceux de leurs enseignants. Et je ne parle pas des parents.

Former des Gandalf, pas des Théoden

Revenons à ma métaphore. Théoden, sous l’emprise de Grima, ne sait pas qu’il est manipulé. Il croit que les mots qu’on lui murmure sont les siens. Il s’affaiblit sans comprendre pourquoi.

Gandalf, lui, connaît la magie noire. Pas pour la pratiquer. Mais pour la détecter. Pour la combattre.

Je veux former des Gandalf. Pas des Théoden.

Des élèves qui comprennent comment fonctionne la manipulation informationnelle. Qui savent identifier un texte généré par IA. Qui peuvent détecter une opération FIMI. Qui ont les outils intellectuels pour résister. Et pour ça, il faut qu’ils manipulent l’outil. Sous ma supervision. Avec ma grille critique. Dans un cadre sécurisé.

On n’enseigne pas la résistance en fuyant le combat.

Cette chaîne YouTube continuera à produire. D’autres apparaîtront. L’IA va continuer à progresser. La guerre informationnelle va s’intensifier. Mais si j’ai réussi, à travers cet article, à vous donner les clés pour détecter, analyser, résister, alors j’ai fait mon boulot. Et si vous êtes enseignant, je vous demande : n’ayez pas peur de l’IA. Apprivoisez-la. Décortiquez-la. Enseignez-la. Parce que vos élèves en auront besoin.

Pas pour l’utiliser bêtement. Mais pour s’en méfier intelligemment.