LIGNE ÉDITORIALE

Lancer une revue pour éclairer les problématiques liées au Big Data (qui mêle histoire, linguistique et sciences de l’information et de la communication) n’est pas chose aisée, car beaucoup ont été créées récemment. L’association francophone des humanités numériques « Humanistica » propose en effet, depuis 2017, une approche analytique globale entre Big Data et sciences humaines. Ailleurs et depuis 2015, on peut noter l’existence de la revue fondée par F. Kaplan « Frontiers in DH » qui a déjà publié des articles impliquant déjà Big data / histoire / linguistique, certes en Anglais. Pour ce qui est du quantitatif en histoire, on doit se rappeler plus en amont de l’existence de la revue « Histoire et mesure » apparue à la fin des années 1980 et dont le premier article évoquait déjà des problématiques informatiques globales. En somme, il nous fallait proposer un regard différent.

Mais comment ? Quel néologisme pourrait-on trouver pour capter l’attention de nos lecteurs ? Une formule existe depuis 2009, « Culturomique » qui cristallise le pont de plus en plus visible entre la culture et le numérique. Il fallait pour accentuer l’identité de notre projet, marquer une différence. Cette revue en ligne aurait pu ainsi s’intituler par exemple « Etudes Culturomiques ». Mais le principe est que toute dénomination doit parler immédiatement, au public sans avoir besoin d´aucun mode d´emploi qui soit. La formulation « Etudes Culturmétriques » nous a alors particulièrement convaincus.

Autre néologisme donc. Provoquer pour exister et créer un lieu de débat, y compris pour ceux qui sont sceptiques. La

discussion permettra toujours un apport méthodologique que l’on retrouve régulièrement dans un autre espace de discussion récent, encadré par une autre jeune revue intitulée « Etudes Digitales » mise en ligne également en 2017.

Comment singulariser notre regard durant une année aussi féconde? Un nom, mais pas seulement. Il fallait aussi réduire notre champ sur un angle spécifique mêlant Histoire/ Linguistique et sciences de l’information et de la communication.

Notre publication aura donc pour but de proposer des analyses structurelles dans le domaine spécifique de ces trois domaines de recherche combinés et synchronisés. L’intérêt sera ici d’éclairer les signes d’une nouvelle méthodologie scientifique et de rassembler des chercheurs sur une nouvelle façon de percevoir et d’analyser l’Histoire des Hommes face au « Big Data ». Cette notion apparue dans les années 1990 constitue aujourd’hui un défi technologique qui a bousculé toutes les sciences. Ces dernières vivent une mutation qui se manifeste souvent par une rupture épistémologique. Où se situe la rupture ?

En juin 2008, Chris Anderson rédacteur en chef de Wired Magazine publiait un article au titre provocateur : « The End of Theory : the Data Deluge Makes the Scientific Method Obsolete ». Selon lui, lorsque nous disposerons de suffisamment de données, les nombres parleront d’eux-mêmes et les corrélations ainsi dévoilées remplaceront les relations de causalité que postulent les théories. La science pourra se développer sans faire d’hypothèses explicites. Pourtant tout n’est pas encore dit.

Cette approche de Chris Anderson a été déconstruite par Danah Boyd et Kate Crawford (« 6 provocations about big data »). Les promoteurs du Big Data occultent en effet que les données ne sont jamais brutes (« raw data is an oxymoron ») mais issues d’un processus social et que la question d’un corpus n’est pas neutre. Il y a des études par exemple sur la non représentativité de corpus tels que celui de « google books » ou du « like » de Facebook, fonctionnalité qui engendre beaucoup de données, mais qui sont peu exploitables car trop liées à la finalité commerciale de Facebook ce qui les rend peu interprétables.

Qu’en est-il pour l’Histoire face aux problématiques de l’informatique et des technologies de l’information et de la communication ?

Il existe des antécédents que nous pouvons rappeler : l’histoire cliométrique, plutôt anglo-saxonne, ou l’histoire quantitative dirigée par l’école des Annales à partir des années 1950-1960 ont été les objets de nombreuses critiques dans les années 1970 par la micro-histoire. Depuis cette critique a été reprise dans le numéro récent des Annales consacré au « History Manifesto » qui remet en doute les différentes échelles d’analyse de l’Histoire. Macro-histoire et micro-histoire peuvent ainsi se heurter dans leurs conclusions. Autre aspect de cette crise épistémologique, la place de l’historien dans ses recherches.

Nous verrons ainsi que beaucoup d’historiens ont pu « mettre en intrigue » leur discours et ont pu se retrouver dans le champ du littéraire et du romanesque selon le chercheur américain Hayden White. Tout discours ou écrit en histoire ne serait, selon cet historien, que mise en littérature, une sorte de « Making Fiction Operation ». Toute l’histoire et son écriture devenant ainsi tragiquement subjectives. Donc doute sur les données massives et doute sur la subjectivité de l’historien seront ici à garder comme toile de fond de toutes nos analyses futures.

L’autre mutation de ce traitement massif des données, c’est l’approche linguistique de notre revue. Pour ce qui est de ce domaine, nous interviendrons dans le champ de la linguistique informatique, de la linguistique des corpus, et des modèles probabilistes. Là aussi, l’arrivée de l’ordinateur quantique a modifié toutes les méthodes du traitement des données facilitant la construction d’une information pertinente et riche de sens.

Le calcul intensif et la modélisation permettent de générer une visualisation infinie des données. L’ère du « Big Data » se caractérise donc par son pragmatisme, conduisant les « Data Scientists » à minimiser l’utilisation d’apriori dans la construction des modèles et à mesurer leur qualité par leur pouvoir prédictif. Nombreux sont les plateformes « Factory Lab » qui proposent une lecture massive de données textuelles dans une perspective historique et linguistique. Aux Etats-Unis, beaucoup de projets ont vu le jour. Le laboratoire « Cesta » à Stanford apparu en 2012 se consacre à des analyses massives de textes dans le temps et l’espace notamment en utilisant des applications telles que « Palladio » ou « Lacuna Stories ».

Auparavant, nous avions vu émerger un « l’Observatoire Culturel » sur Harvard dirigé par Jean-Baptiste Michel qui a pu entreprendre avec Google, la mise en ligne ouverte à tous de l’application intitulée « N-gram-Viewer » (visualisateur de fréquence de mots) et mise en ligne dès 2010.

A l’aide de ce programme, on peut par exemple étudier l’édition mondiale produite durant les 19ème et 20ème siècles. Cet instrument numérique en ligne sur l’Internet peut permettre une approche assez précise des occurrences lexicales des deux derniers siècles. La volumétrie des Big Data permet de repérer des signaux faibles et rares. Grâce à ces nouvelles technologies de l’information, ce qui est rare devient vraiment observable. La détection des anomalies est facilitée. Les textes et images ainsi automatisés permettent un traitement massif des données et leur corrélation peut permettre de déconstruire, par exemple, les mythes qui se sont accumulés.

eric.bailble@gmail.com

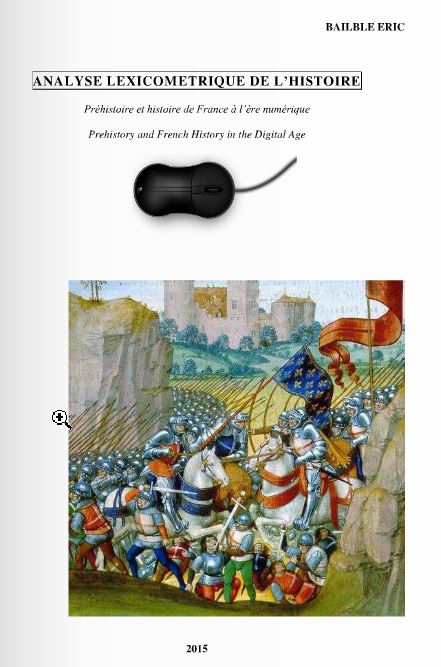

Analyse lexicométrique de l’histoire

Éric Bailblé

Une présentation des Big Data